Aujourd’hui nous allons déployer une instance de Ollama, un modèle d’IA opensource sur Linux.

Il est recommandé d’utiliser une machine ayant des capacités importantes afin de faire tourner les modèles, ma machine de test ne dispose pas de ces ressources, les performances seront donc dégradées.

On installe tout d’abord les dépendances :

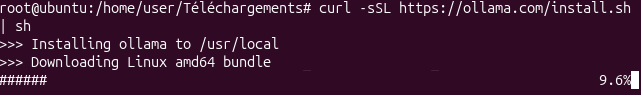

apt install curl gitOn télécharge ensuite ollama :

curl -sSL https://ollama.com/install.sh | sh

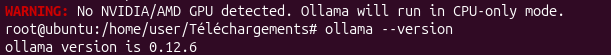

On vérifie ensuite que ollama est bien installé :

ollama --version

Comme indiqué précédemment mes ressources sont limitées d’où le warning.

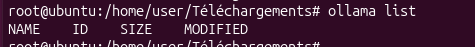

Avec la commande ollama list, vous pouvez voir les modèles présents (ici aucun) :

Ollama propose différents modèles. En voici quelques exemples :

| Modèle | Taille | Usage | Commande |

|---|---|---|---|

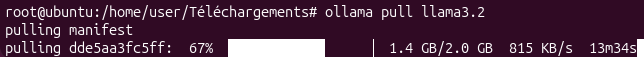

| Llama 3.2 | 2-3 GB | Usage général, débutant | ollama pull llama3.2 |

| Mistral | 4 GB | Code et texte | ollama pull mistral |

| CodeLlama | 4 GB | Spécialisé code | ollama pull codellama |

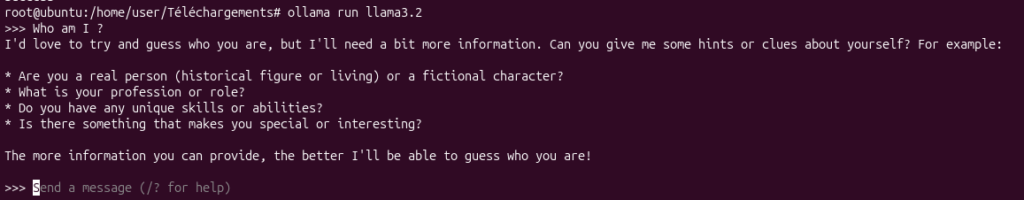

On va tester le modèle llama :

On va ensuite lancer le moteur d’IA :

ollama run llama3.2